出品 | 搜狐科技

作者 | 梁昌均

过去十年里,人工智能伴随着深度学习的崛起迎来了生机勃勃的黄金发展浪潮,但在兴奋、狂热过后,行业也趋于冷静。Gartner不久前发布的《2022年人工智能技术成熟度曲线》报告显示,深度学习目前仍处于泡沫破裂低谷期。

任何一项技术的发展都不会是一帆风顺。自1956年人工智能的概念被首次提出,人类数次因它的突破而激动,也因它的低潮而失望。而自20世纪90年代进入第三波浪潮后,人工智能总是惊喜不断。

从1997年深蓝计算机打败象棋世界冠军,到2016年AlphaGo战胜围棋世界冠军,再到AlphaFold破解了出现50年之久的蛋白质分子折叠结构问题;从语音识别、图像翻译,再到自动驾驶,以及最近引发争议的AI绘画等,人工智能屡次刷新着人类对它的认知。

人类距离想要制造出一台会思考的机器的梦想,似乎越来越近。但与此同时,人工智能、机器学习和深度学习本身的缺陷越发受到关注,有关技术伦理和社会治理问题也越发突出。不少观点认为,深度学习已走进死胡同,人工智能陷入瓶颈期。

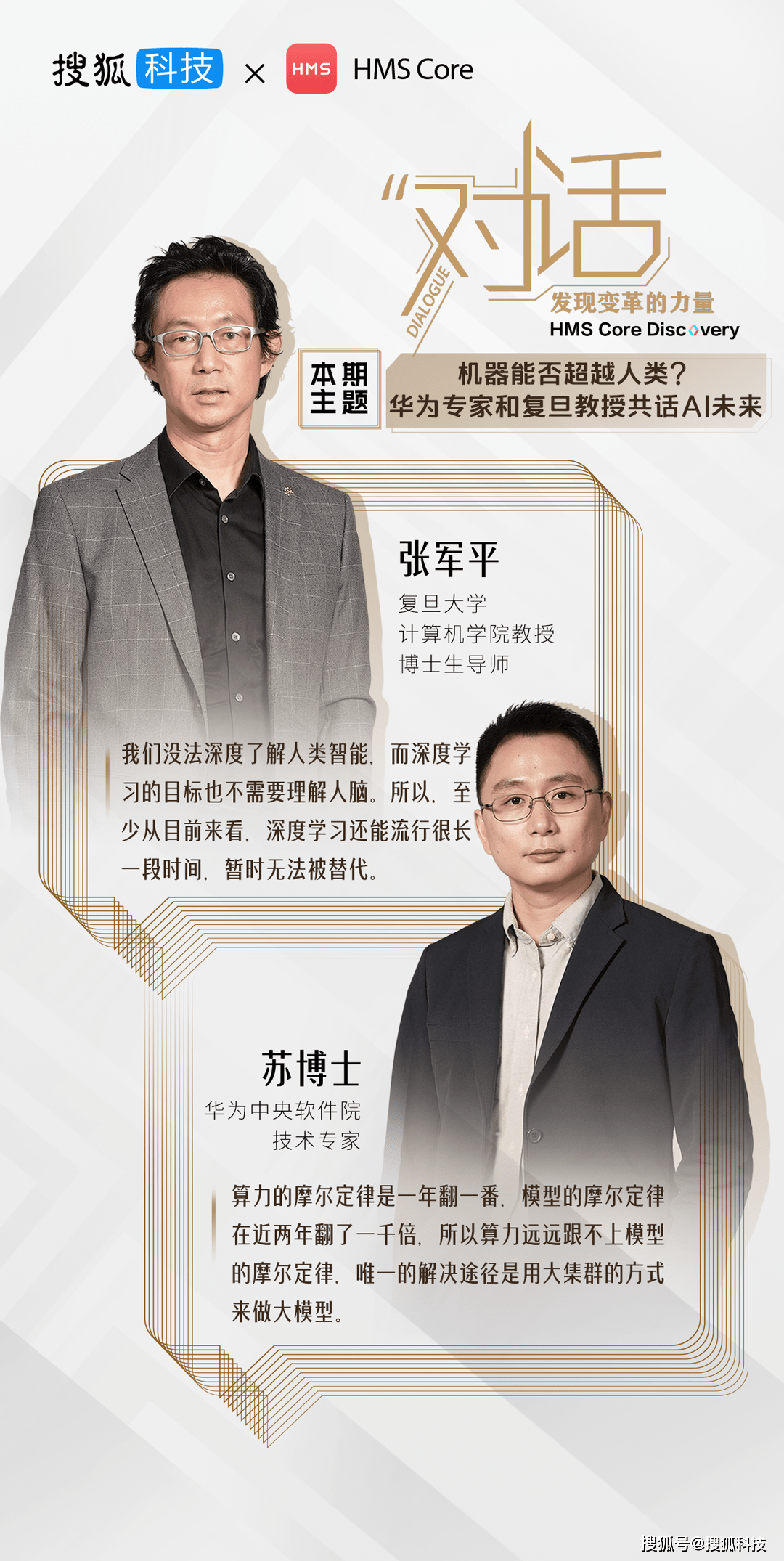

作为推动人工智能发展的关键技术,机器学习和深度学习面临什么挑战?未来将如何演进?人工智能又是否能无边界扩张?搜狐科技《对话》栏目邀请到复旦大学计算机科学技术学院教授、博士生导师张军平,以及华为中央软件院技术专家苏博士对此进行了探讨。

张军平表示,深度学习目前被普遍用来做预测,但这在人工智能里只占据很小的部分,两者之间的差异导致外界对人工智能或深度学习有所失望。他认为,深度学习仍可以维持很长一段时间,目前还没有看到新的算法能够替代它。

苏博士认为,深度学习现在已逐步走出低谷期,背后的核心是数据和算力驱动,而算力将会是未来的发展瓶颈。他提到,深度学习也在学习吸收其他算法的特点,从而能够推动自身持续发展。

对于人工智能的边界问题,张军平认为,人工智能的同化效应越来越明显,而深度学习引发了端到端的革命,但也存在不可解释性、数据隐私等风险。苏博士提到,人工智能远没有达到克隆人技术对社会伦理的冲击程度,应鼓励它的发展,但需加强对个人数据的保护。

两位嘉宾均认为,人工智能在某些方面已超越人类,但未来想要全面超越人类智能,存在很大难度,人机关系最可能的形式则是人机协同。

以下为访谈实录:

一、机器学习发展现状

搜狐科技:近日一幅名为《太空歌剧院》的AI画作获得了数字艺术类别的冠军,这引发了争议,如何看待AI绘画获奖?

苏博士:这个比赛是艺术性的比赛,艺术方面还是应该奖励人的创造力、天赋、努力等。AI作画虽然可能会比较有意思,但本身是计算机的事情,它去参加计算机比赛可能比较合适。此外,AI本身有很大的概率会生成跟以前某位画家相似度比较高的图像或图片,这时候可能会有版权的问题。

搜狐科技:除AI绘画,还有AI生成小说、音乐等,作为一名音乐爱好者,是否愿意尝试用AI来写词?AI自动生成背后用到的是什么技术?

张军平:AI生成是一种生成式的模型,这个模型是在2022年诞生,叫稳定扩散模型。现在AI绘画是用高斯模型来做,它首先是拿一幅画,然后加噪声进去,让画变模糊,如此一步一步最后就变成一张图片,人工智能则是用神经网络反过来学,学好以后就可以生成。随着算力的提升,它可以做得比原来更精细、更好。对大部分的音乐作曲来说,如果不是特别追求艺术性,那可以用AI来做。写词最重要的是要形成共鸣,人工智能还无法很好抓住。

搜狐科技:AI生成算是比较新的应用,类似语音识别、图像识别等都比较常见。从机器学习的角度来看,这些领域有哪些提升的空间?

苏博士:在语音识别方面,同样是讲一句话,可能是负面,也可能是正面,以前很难识别出来。现在的AI技术则可以把语调的情感等融合进来,使语音合成加入很多情感信息,使得人跟机器的沟通更加流畅。图像这块最多的是图像分类,OpenAI的CLIP模型能够做很多开放域的检测,通过把文本信息引入到图像识别领域,带来非常大的突破,特别在视频监控领域。在这些领域,随着算法不停扩展,AI能力越来越强,有一些基本上超过了人的水平。

搜狐科技:Gartner报告显示深度学习目前处在泡沫破裂低谷期,预计它什么时候能够走出低谷期?

张军平:现在都在打着人工智能这块牌子拿深度学习做预测,但预测在整个人工智能里可能只占了很小一块。所以从外界来看,深度学习和人工智能之间就会产生差异或差距,导致大家对人工智能或对深度学习会有一点点失望。人工智能现在是第三次高潮,它有可能会因为这个差异掉到低谷去,一旦掉进去,可能要走得长一点。

苏博士:深度学习在三四年前可能是低谷期,现在已经逐步走出来了,像谷歌提出的Transformer架构,给文本领域带来革命,包括搜索也用了深度学习。它什么时候会面临瓶颈呢?核心在于算力,因为现在的AI很多都是靠数据跟算力驱动的。如果有更多的数据、更大的算力,加上模型规模的扩大,效果还是能够持续提升。

搜狐科技:机器学习和深度学习存在着天然缺陷,比如说黑箱、不可信、脆弱性等,这些缺陷对于AI的发展是致命的吗?如何解决?

张军平:我觉得它不是致命的,而是有帮助的东西。深度学习把预测能力做到非常强的时候,却缺少有效的办法找到非常清楚的解释性,但这恰恰又是人工智能必须要做得到的。怎么平衡这两个方面?我觉得未来做人工智能可能需要把对预测能力的目标稍微放松一些,不要追求极致。

苏博士:从产业的角度来看,一般不会直接应用深度学习算法的结果,而是会有后处理,也就是过滤匹配的机制。比如AI生成文本,一旦生成不合规用语,可以把它过滤掉,重新再生成。从应用角度来说,整个端到端流程里不仅是AI,背后会有很多其他工具来辅助AI。

二、大模型发展趋势和挑战

搜狐科技:近年来火热的大模型被视为迈向通用人工智能最有潜力的方向,如何看待大模型竞赛?

张军平:大模型比较烧钱,这是大模型的通病。另外大模型和人的智能还有区别,人一天消耗的能量很小,但大模型很费电。有企业花5万美元只在某一个数据上提高了3‰的性能,成本上也非常不合算。

苏博士:产业界比较看好大模型方向,但只有大企业、大机构才能承担算力的成本,国外主要就是谷歌、OpenAI、DeepMind、微软这些互联网巨头。华为有自己的MindSpore框架,为大模型做了很多基础设施,也跟很多高校合作,推出将近有20个大模型。未来大模型要走得更远,肯定得有科研界高效的介入。产业界更多还是看落地,而高校会做很多创新。

搜狐科技:大模型需要大数据,这离不开底层算力和芯片的支撑。在后摩尔定律时代,应该如何去应对这样的挑战?

张军平:人工智能里除大模型外,还有小而精的蒸馏学习。比如自动驾驶,不可能把一个超大的模型部署到汽车上面,可能就是需要比较小的芯片。在深度学习兴起以前,有一个叫Adaboost的算法,也就是弱分类器,通过上千个弱分类器的集成其实也能得到很好的性能。

苏博士:大模型在应用领域现在可能还存在困难,算力本身还跟不上。除了大模型,还可以通过剪枝、蒸馏、量化等一系列技术把大模型做小,把小模型做得更小,做得更高效;还可以结合特定的领域,专门去做一个模型,从而有针对性的优化。

算力的摩尔定律是一年翻一番,模型的摩尔定律在最近两年翻了一千倍,所以算力远远跟不上模型的摩尔定律,唯一的解决途径是用大集群的方式来做大模型。这需要很多底层软件,包括芯片到整个底层技术软件的开发。比如华为的MindSpore,就是专门针对这样的场景,可以很快把需要大算力的模型在大集群上面跑起来。所以在方向上,一个是从算法层面需要把模型做得更高效、更小,另一个就是从系统软件层面,抛开AI的底层,去把计算做得更高效,支撑深度学习超大算力的需求。

搜狐科技:Transformer是机器学习和大模型目前的主流基础架构,它会是终极框架吗?业界在做哪些探索?

苏博士:Transformer肯定不会是终极框架,它本身学习效率比较低,参数效率和计算效率也不是特别高,本身也有很多稀疏性。现在学术界有在研究类脑计算,做脉冲神经网络,就是模拟人脑的脉冲信号,用稀疏的特性来设计一些新的算法。但未来具体有什么新的算法能替代Transformer架构,目前还没有看到,很长一段时间还是会基于Transformer架构,到某一天可能量变积累到质变,出现新的架构。

三、深度学习和人工智能未来趋势

搜狐科技:流行学习、稀疏学习、深度学习等先后成为机器学习热点,深度学习还能维持多久?会不会有新的算法取代它?

张军平:如果只谈预测,目前可能很难有其他方法能够抗衡深度学习。比如前面说的类脑,包括脉冲神经网络,都还处在探索阶段。我们也没有办法去深度了解人类的智能,但深度学习恰好不需要去理解人的大脑,所以至少从目前来看,深度学习还可以维持很长一段时间。如果只是关心预测,或者产业落地,深度学习暂时还无法被替代。

苏博士:深度学习本身也是从非常多的算法发展过来的,包括高维稀疏、随机梯度下降等能力就是结合很多传统机器学算法融入而来,现在也在吸收稀疏学习、流行学习等算法的一些特点。真正出现替换深度学习的算法,现在还没看见,但深度学习可以吸收其他算法的特点,也能够持续发展。

搜狐可以:人工智能目前已经在不少领域开花结果,似乎万物都可AI,是否应该给AI设置一个界限?

张军平:人工智能近年来有非常大的突破,我把它总结为同化效应。以前可能有行业的差异,但深度学习出来以后,有了端到端的概念,出现端到端的革命,即就是万物都可AI。但它到底行不行,也有很多人质疑,比如医疗强调可解释性,医生开药会告诉病人原因,但深度学习只能开药,不会告诉病人为什么,导致很多医生不敢用这些技术。

苏博士:AI本身是一个技术,技术可能还是要鼓励,不要给它设置条条框框。技术领域的边界,最有名的就是克隆人,因为克隆人本身会对整个社会底层的伦理道德产生冲击。但AI其实远远没有达到这个程度,还不会造成很大的冲击。

搜狐科技:人工智能在带来便利和效率的同时,相关的技术伦理和社会伦理的风险也愈发突出,如何来规避和解决这些风险?

张军平:我觉得有两个风险需要考虑,第一是数据本身,它会泄露隐私;另外在大模型训练的时候,也有很多数据可能会被泄露。有些公司为了效益,可能收集的是用户完整数据的一部分,但可以通过A公司、B公司、C公司拼出来,如何去预防这样的风险也是问题。

苏博士:最重要的是要加强对个人数据的保护,比较理想的方式是匿名化,但它可能跟现在很多法律法规有冲突,所以数据保护就显得非常重要,也需要权威机构出台法律来保护数据。此外,数据本身有很多偏见,比如存在歧视,这可以通过模型本身引入新鲜的知识,把偏见给克服掉,但最关键的还是数据保护,加强应用的监管。

搜狐科技:看向未来,机器什么时候能够超越人的智能,人类和AI又应该是怎样的一个关系?

张军平:人工智能就是机器,它可能会在某一些方面超越人类,但要超越人的整体智能还有难度。在人自己都没办法把自己了解清楚之前,怎么能够使做出来的机器超越人的智能呢?人和机器的关系,我觉得过度地相信机器不行,过度相信人也不行,目前最可能的方式是人机协同,也就是混合增强智能。

苏博士:现在人工智能在特定领域可能会比人好,但要在各个方面超越人的智能,目前来看比较困难,我个人觉得也没有这个必要。可以把AI当作一个工具,来辅助我们的工作和科研,来提高生产效率,通过AI来替代一些枯燥乏味的工作,把人类解放出来,去做更加有创造力的事情。